未经授权的人工智能正在盗取你公司的数据,这都要归功于你的员工

企业面临的未授权AI风险

文章重点

员工无授权使用AI,导致公司敏感资讯流失。74的ChatGPT使用来自非公司帐户,可能影响数据安全。建议企业与AI供应商签署有数据使用限制的授权合约。许多公司的员工正在利用未授权的AI工具,而里面包含法律文件、源代码及其他敏感企业资料,这使得资讯技术领导者面临日益加重的影子AI困境。

根据Cyberhaven Labs的一项最新研究,许多组织的员工在CIO和CISO不知情的情况下,广泛使用未授权的AI模型。约74的ChatGPT工作中使用是透过非企业帐号进行,意味著这些AI可能有能力使用或训练这些数据。根据 Cyberhaven的Q2 2024 AI采用与风险报告,超过94的Google AI如Gemini和Bard的工作使用也来自非公司帐户。

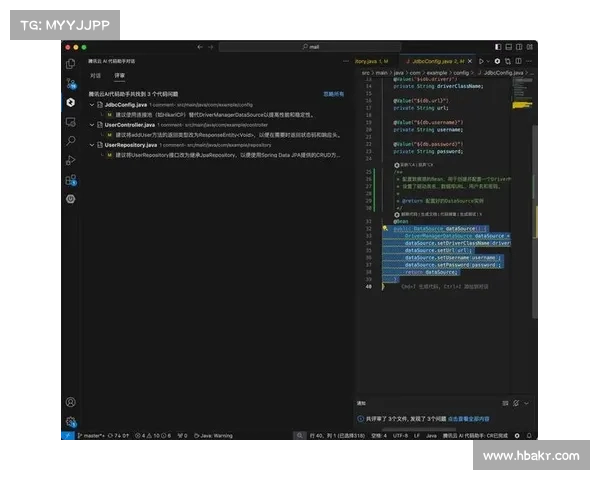

报告补充指出,几乎83的法律文件通过非公司帐户与AI工具共享,约一半的源代码、研究与开发材料以及HR和员工记录也进入了未授权的AI。

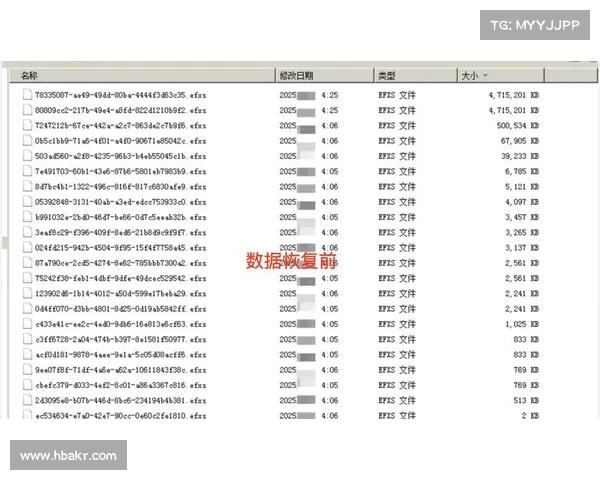

从2023年3月到2024年3月,所有AI工具中输入的数据量几乎增加了五倍。报告提到,“最终用户正在以比IT部门更快的速度采用新的AI工具,促进了影子AI的持续增长。”

数据去向

同时,许多用户可能并不清楚在将公司的数据分享给未授权AI后会发生什么事情。例如,ChatGPT的使用条款指出,所输入内容的所有权仍然属于用户,但ChatGPT可以使用该内容来提供、维护、开发和改进其服务,这意味著它可能会以共享的员工记录进行自我训练。用户可以选择不让ChatGPT使用他们的数据进行自我训练。

黑洞加速器安卓正版迄今为止,尚未有关于大型公共AI泄露公司机密的高调报导,但安全专家担心一旦AI获取了数据,会发生什么情况。5月28日,OpenAI宣布成立一个新的安全与安全委员会,以应对这些担忧。

Varonis的现场CTO Brian Vecci表示,评估共享机密或敏感信息与公开可用AI的风险是非常困难的。考虑到这些披露会给公司带来麻烦,他怀疑像谷歌或OpenAI这样的公司会允许他们的AI泄露敏感商业数据。

尽管如此,一些安全专家指出,关于AI开发者可以如何处理用户提供的数据的规定并不多。Vecci表示,未来几年会推出更多AI模型。

“当我们走出OpenAI和谷歌的范畴时,将会出现其他工具,”他说。“将会有那些免费、快速但由未知人控制的AI工具。您的员工可能正在使用它们,并可能在使用中泄露源代码和财务报表,这将带来更高的风险。”

冒险行为

向任何未授权的AI分享公司或客户数据都会带来风险,无论该AI模型是否会对数据进行训练或与其他用户共享,因为这些信息现在已经存在于公司的墙外。Bedrock Security的CEO Pranava Adduri补充道。

Adduri